AI 챗봇 기술의 원리?

ChatGPT, AI 챗봇에 대한 열기가 식을줄 모르고 있습니다. 미국에서 변호사 시험, 의사시험까지 합격했다고 하구요. 대부분의 대학에서 공식적으로 ChatGPT를 사용한 과제나 논문을 금지시키는 일까지 생겨나고 있습니다.

작게는 엑셀활용에서 영어배우기 등 다양한 분야로 ChatGPT의 사용성을 넓혀가고 있습니다. 인터넷이 처음 나왔을때 처럼 큰 사건이라고 이야기 했던 빌게이츠말처럼 이제 어떻게 사용하면 좋을지, 뭐가 문제가 될지 하나씩 현실로 접목되어 나타나는 것 같습니다.

오늘은 이 ChatGPT의 기술적인 근간이 되는 이야기 입니다. 대부분 인공지능, ChatGPT도 그냥 인공지능의 하나라고 이야기 하지만, 이게 너무나 광범위하고 폭넓은 분야라서 다 똑같은 인공지능이라고 이야기 하는게 사실은 맞지가 않습니다.

ChatGPT는 사실 이러한 광범위한 분야에서 언어처리에 대한 부분을 중점으로 개발, 적용된 사례라고 볼수 있습니다. 언어처리, 벡터화 NLP 부분은 이전에 이야기 드린 아래 내용을 참고해 보세요.

2023.02.19 - [IoT, AI] - AI Chat GPT가 인간의 말을 이해하는 법

AI Chat GPT가 인간의 말을 이해하는 법

인간의 말을 컴퓨터가 이해할 수 있도록 하기 위한 '벡터화'의 이야기 인간의 말을 컴퓨터가 이해하는 방법은 인공지능 분야 중 자연어 처리(Natural Language Processing, NLP) 기술을 이용하는 것입니다

penguin5.tistory.com

대규모 언어 모델(Large Language Model, LLM)이란?

이전 포스팅에서는 컴퓨터가 어떻게 인간의 언어를 받아들이고 이해하는 지에 대해서 말씀 드렸고, 오늘은 이 습득된 언어를 어떻게 내부적으로 처리하는지에 대한 부분입니다.

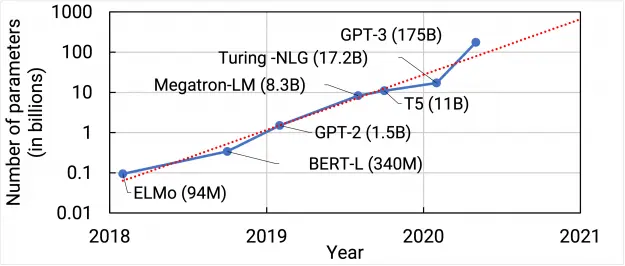

대규모 언어 모델(Large Language Model, LLM)은 대규모 데이터셋을 사용하여 훈련된 자연어 처리 모델을 말합니다. 이러한 모델은 딥 러닝 알고리즘을 기반으로 하며, 수억 개 이상의 문장을 학습할 수 있습니다. 이러한 모델은 자연어 이해, 생성, 번역, 요약 등 다양한 자연어 처리 작업에서 놀라운 성능을 발휘하고 있으며, 최근 GPT-3(ChatGPT의 모델)와 같은 대규모 언어 모델들이 자연어 생성 분야에서 큰 관심을 받고 있습니다.

대규모 언어 모델(LLM)은 2018년 구글의 BERT(Bidirectional Encoder Representations from Transformers)가 등장하면서 크게 주목받기 시작했습니다. 이후 2019년 OpenAI에서 GPT-2(Generative Pre-trained Transformer 2)를 발표하면서 대규모 언어 모델 연구가 한층 활성화되었습니다. 이후 GPT-3, T5(Text-to-Text Transfer Transformer), GShard 등 다양한 대규모 언어 모델이 개발되어 현재까지도 연구와 개발이 지속되고 있습니다.

주요 대규모 언어 모델과 해당 모델을 주도하는 기업은 다음과 같습니다.

- BERT: 구글

- GPT-2, GPT-3: OpenAI

- T5: 구글

- GShard: 구글

- Megatron: NVIDIA

- DeBERTa: 페이스북

- ELECTRA: 구글, 페이스북

각 모델들에 대해서 자세하게 알아보면,

BERT: BERT(Bidirectional Encoder Representations from Transformers)는 2018년 Google에서 개발한 사전 훈련된 변환기 기반 언어 모델입니다. 다양한 자연어 처리 작업에서 최첨단 성능을 달성했으며 다음에서 널리 사용됩니다. 산업계와 학계. 단어 사이의 의미론적 관계를 포착하는 능력과 미세 조정을 통한 다양한 작업에 대한 적응력이 강점입니다. 약점에는 큰 크기와 높은 계산 요구 사항이 포함되어 리소스가 제한된 장치에서의 사용이 제한됩니다. 향후 개발은 효율성을 개선하고 리소스가 적은 시나리오를 최적화하는 데 중점을 둘 수 있습니다.

GPT-3: GPT-3(Generative Pre-trained Transformer 3)은 OpenAI가 2020년에 개발한 최첨단 언어 모델입니다. 글쓰기, 챗봇, 언어 번역. 그것의 강점은 최소한의 입력으로 고품질 텍스트를 생성하는 크기와 기능에 있습니다. 약점에는 높은 계산 요구 사항과 교육 데이터의 잠재적 편향이 포함됩니다. 향후 개발은 이러한 제한 사항을 해결하고 효율성을 개선하는 데 중점을 둘 수 있습니다.

T5: T5(Text-to-Text Transfer Transformer)는 2020년 Google에서 개발한 언어 모델입니다. 일련의 변환을 통해 입력 텍스트를 출력 텍스트로 변환하여 광범위한 자연어 처리 작업을 수행할 수 있는 능력이 주목됩니다. . 그것의 강점은 다양성과 단일 모델로 여러 작업을 수행할 수 있는 능력을 포함합니다. 약점에는 높은 계산 요구 사항과 교육 데이터의 잠재적 편향이 포함됩니다. 향후 개발은 효율성을 개선하고 이러한 제한 사항을 해결하는 데 중점을 둘 수 있습니다.

GShard: GShard는 2020년 Google에서 개발한 분산 학습 프레임워크입니다. BERT 및 T5와 같은 대규모 모델을 여러 장치에서 효율적으로 학습하도록 설계되었습니다. 그것의 강점은 확장성과 많은 양의 데이터를 처리하는 능력을 포함합니다. 약점에는 복잡성과 통신 오버헤드 가능성이 있습니다. 향후 개발은 효율성을 개선하고 통신 오버헤드를 줄이는 데 중점을 둘 수 있습니다.

Megatron: Megatron은 2019년 NVIDIA에서 개발한 대규모 언어 모델입니다. 분산 학습을 사용하여 수십억 개의 매개변수로 모델을 학습하도록 설계되었습니다. 그것의 강점은 확장성과 많은 양의 데이터를 처리하는 능력을 포함합니다. 약점에는 높은 계산 요구 사항과 통신 오버헤드 가능성이 있습니다. 향후 개발은 효율성을 개선하고 통신 오버헤드를 줄이는 데 중점을 둘 수 있습니다.

DeBERTa: DeBERTa(Decoding-enhanced BERT with disentangled attention)는 2020년 Microsoft Research Asia에서 개발한 언어 모델입니다. 주의 메커니즘을 풀고 디코딩을 개선하여 BERT의 성능을 개선하도록 설계되었습니다. 그것의 강점은 다양한 자연어 처리 작업에 대한 장거리 의존성과 향상된 성능을 포착하는 능력을 포함합니다. 약점에는 계산 요구 사항과 과적합 가능성이 포함됩니다. 향후 개발은 효율성을 개선하고 과적합의 위험을 줄이는 데 중점을 둘 수 있습니다.

ELECTRA: ELECTRA(Efficiently Learning an Encoder that Classifies Token Replacements Accurately)는 Google에서 2020년에 개발한 언어 모델입니다. 더 작은 데이터 하위 집합을 학습하여 사전 학습 언어 모델의 효율성을 개선하도록 설계되었습니다. 그것의 강점은 효율성과 더 큰 모델에 필적하는 성능을 달성하는 능력을 포함합니다. 약점에는 사전 훈련 작업에 대한 의존성과 훈련 데이터의 잠재적 편향이 포함됩니다. 향후 개발은 사전 교육 작업의 유연성을 개선하고 교육 데이터의 잠재적 편향을 줄이는 데 중점을 둘 수 있습니다.

대규모 언어 모델(LLM)의 주요 적용 사례는 다양합니다.

몇 가지 예를 들면 다음과 같습니다.

- 자연어 이해(NLU) 및 자연어 생성(NLG) : LLM은 자연어 이해 및 생성 분야에서 사용되며, 대화형 AI, 챗봇, 기계 번역, 요약, 질문 답변 시스템 등에서 활용됩니다.

- 정보 검색 : LLM은 검색 엔진에서 사용됩니다. 이를 통해 보다 정확하고 관련성 높은 검색 결과를 제공할 수 있습니다.

- 음성 인식 : 음성 인식 분야에서 LLM은 발음, 억양, 강세 등 다양한 음성 특징을 학습하여 음성 인식의 정확도를 높일 수 있습니다.

- 이미지 캡션 생성 : LLM은 이미지와 관련된 캡션 생성 분야에서도 사용됩니다. 이미지에 대한 특징을 학습하고 이를 기반으로 이미지에 대한 설명을 생성합니다.

- 소셜 미디어 분석 : LLM은 소셜 미디어에서의 감성 분석, 텍스트 분류 등 다양한 분석 작업에서 사용됩니다. 이를 통해 대량의 텍스트 데이터를 분석하고 특정 키워드 또는 감성에 대한 분석 결과를 도출할 수 있습니다.

대규모 언어 모델(LLM)은 ChatGPT덕분에 자연어 처리 분야에서 최근 큰 인기를 얻고 있는 기술로, 대규모의 텍스트 데이터를 이용해 학습된 모델입니다.

LLM은 주로 특정 자연어 처리 태스크(번역, 요약, 질문 응답 등)를 수행하기 위해 사용됩니다. 모델은 입력 텍스트를 처리해 텍스트의 의미를 파악하고, 그 의미에 기반하여 출력 텍스트를 생성합니다.

LLM의 구현 예시로는 GPT(Generative Pre-trained Transformer) 모델이 있습니다. GPT 모델은 Transformer 아키텍처를 기반으로 하며, 대규모의 텍스트 데이터로 사전학습된 후 특정 태스크에 fine-tuning을 거쳐 사용됩니다.

예를 들어, GPT 모델을 사용해 문장 생성을 수행하는 경우, 모델에게 문장의 일부를 입력하면 모델은 이를 이해하고 이어지는 문장을 생성합니다. 예를 들어 "The cat sat on the"라는 문장이 입력된 경우, 모델은 "mat" 또는 "chair"와 같은 가능성 있는 다음 단어를 예측하여 문장을 완성합니다.

LLM은 자연어 처리 분야에서 다양한 응용 분야에 사용되고 있으며, 기존에는 사람이 수행해야 했던 많은 자연어 처리 작업을 자동화하고, 보다 정확하고 빠르게 처리할 수 있게 해주는 기술입니다.

대규모 언어 모델(LLM)의 문제점과 한계

대규모 언어 모델(LLM)의 발전은 자연어 처리 분야에서 혁신적인 발전을 이룩했지만, 여전히 몇 가지 문제점과 한계가 있습니다. 그 중 일부는 다음과 같습니다.

- 컴퓨팅 리소스: LLM은 매우 큰 규모의 모델이므로 학습과 추론에 필요한 컴퓨팅 리소스가 많이 필요합니다. 이는 대규모 서버와 GPU 등 비용이 많이 드는 하드웨어를 필요로 하기 때문에 비용 문제가 발생할 수 있습니다.

- 데이터 양: LLM은 학습에 많은 양의 데이터가 필요합니다. 따라서 데이터가 부족한 언어나 분야에서는 성능이 낮아질 수 있습니다.

- 지식과 상식 부족: LLM은 대규모 양의 텍스트 데이터에서 학습됩니다. 따라서 LLM은 데이터에 대한 지식과 상식이 부족합니다. 예를 들어, 인간이 쉽게 이해할 수 있는 상황에서 LLM은 혼동될 수 있습니다.

- 편향성: LLM은 학습 데이터에 따라 편향될 수 있습니다. 예를 들어, 학습 데이터가 특정 인종, 성별, 직업 등에 대한 편견을 포함할 경우, 이러한 편향성이 모델에서 반영될 수 있습니다.

현재 대규모 언어 모델(LLM)은 자연어 처리 분야에서 큰 주목을 받고 있으며, 앞으로도 그 성능이 더욱 향상될 것으로 기대됩니다. 이를 위한 발전 방향은 크게 다음과 같습니다.

첫째, LLM의 크기와 정확도의 개선입니다. 이는 더 많은 데이터와 연산 자원을 이용하여 모델의 크기와 정확도를 높이는 것입니다. 이를 위해서는 대용량 데이터셋과 더 높은 컴퓨팅 자원의 필요성이 대두됩니다.

둘째, LLM의 학습 방법과 효율성 개선입니다. 현재 LLM은 대량의 파라미터를 가지므로 모델 학습에 필요한 계산 리소스와 시간이 많이 소요됩니다. 따라서 더 효율적인 학습 방법과 알고리즘 개발이 필요합니다.

셋째, LLM의 일반화 능력 개선입니다. 현재 LLM은 대규모 데이터셋에서만 우수한 성능을 보이며, 새로운 데이터셋에 대한 일반화 능력은 아직 한계가 있습니다. 이에 대한 개선을 위해서는 다양한 데이터셋과 다양한 분야에 대한 학습이 필요합니다.

넷째, LLM의 응용 분야 확대입니다. LLM은 이미 자연어 이해 분야에서 뛰어난 성능을 보이고 있지만, 향후에는 다양한 분야에도 활용될 가능성이 있습니다. 예를 들어, 음성 인식, 이미지 캡셔닝, 자율 주행 등의 분야에서도 활용될 수 있습니다.

이러한 발전 방향에 따라, LLM은 앞으로 더욱 다양한 분야에서 활용될 가능성이 크며, 인간의 언어 이해와 인터랙션 분야에서의 혁신적인 발전이 예상됩니다.

복잡한 이야기들이 많았는데요..

한가지만 기억하시면 됩니다. ChatGPT를 그냥 인공지능이라고 통칭 부르기에는 분야가 너무 광범위하다. 인공지능의처리 분야중 대규모언어처리(LLM)이 있는데, 정확이 이야기하면 ChatGPT는 대규모언어처리(LLM)모델을 활용한 하나의 어플리케이션 정도로 이해하면 된다.

지금은 이슈와 투자가 기반이 되어 화려하게 등장했지만, ChatGPT가 하나의 질문을 처리해 주는 대가(비용)를 그리고 어쩔때는 거짓정보를 정말 사실처럼 이야기해주는 진실성(?)을 어떻게 해결해야 할지 등이 앞으로의 숙제가 될것 같습니다.